作者 | 青苹果

来源 | 数据实战派

在过去的几年里,AI 语言模型已经可以非常出色的处理一些特定任务。其中,最值得注意的是,它们擅长预测文本字符串中的下一个单词。以搜索引擎和****应用为例,这项技术可以辅助它们进行预测,以获取你准备输入的下一个单词。

最新一代的预测语言模型似乎也学会了一些语言的潜在含义。让人惊叹的是,这些模型不仅可以预测下一个单词,还可以执行似乎需要一定理解才能完成的任务,如问答、文档摘要和故事续写。

这些模型旨在优化预测文本的特定功能,而非试图模仿人类大脑如何执行这项任务或理解语言。但 MIT 神经科学家的一项新研究表明,这些模型的潜在功能类似于人类大脑中的语言处理中心的功能。

这篇论文写道:“我们的研究结果表明,预测性人工神经网络可作为预测语言处理如何在人类神经组织中实施的可行候选假设。这些网络为一个有前途的研究方向奠定了关键基础,即在集成逆向工程的良性循环中将自然语言处理的高性能模型与人类语言理解的大规模神经和行为测量相结合,包括测试模型预测神经和行为的能力,剖析表现最佳的模型以了解哪些组件对高大脑预测性至关重要,利用这些知识开发更好的模型,并收集新数据以挑战和限制未来几代神经上合理的语言处理模型”。

在其他类型的语言任务中,表现良好的计算机模型并未展示出与人类大脑的这种相似性,这为人脑可能会使用下一个单词预测来驱动语言处理提供了证据。

认知神经科学的 Walter A. Rosenblith 教授 Nancy Kanwisher 说,“模型预测下一个单词的能力越强,就越符合人类的大脑”。他是 MIT 麦戈文脑科学研究所和大脑、心智和机器中心(CBMM, Brain Research and Center for Brains, Minds, and Machines)的成员,也是这项新研究的作者之一。

“令人惊讶的是,这些模型拟合得如此之好,这也有力地暗示出,也许人类语言系统正在做的就是预测接下来会发生什么。”

该研究论文题为“The neural architecture of language: Integrative modeling converges on predictive processing”,已发表在 Proceedings of the National Academy of Sciences 上。

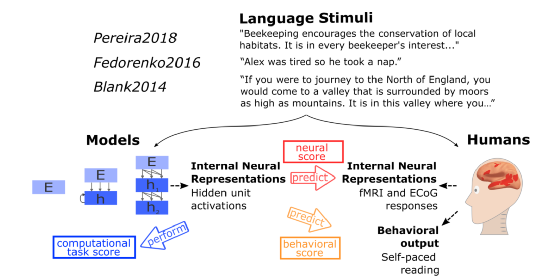

语言处理的人工神经网络模型与人类语言处理的比较。实验测试了不同模型的效果预测人类神经活动(fMRI 和 ECoG)的测量值和语言理解过程中的行为。候选模型范围从简单将模型嵌入到更复杂的循环和变压器网络中。刺激范围从句子到段落再到故事,并且被输入到模型,以及呈现给人类参与者(视觉或听觉)。模型的内部表征在三个主要维度上进行评估:预测人类神经表征的能力;以阅读时间的形式预测人类行为的能力;执行下一个词预测等任务的计算能力。

做预测任务

这种新的、高性能的预测下一个单词的模型属于深度神经网络模型的范畴。这些网络包含计算“节点”,它们形成不同强度的连接,以及以规定的方式在彼此之间传递信息的层。

在过去的十年里,科学家们用深度神经网络创建了视觉模型,可以像灵长类大脑一样识别物体。MIT 的研究也表明,视觉物体识别模型的潜在功能与灵长类视觉皮层的组织相匹配,尽管这些计算机模型并不是专为模仿大脑而设计的。

在这项新研究中,MIT 研究团队采用了类似的方法,以比较人脑中的语言处理中心和语言处理模型。

他们分析了 43 种不同的语言模型,涵盖一些对单词进行预测优化的模型。其中包括 GPT-3(生成式预训练 Transformer 3),它可以依据给出的提示,生成与人类手动生成相类似的文本。而其他的模型则旨在执行不同的语言任务,比如在句子中填空。

由于每个模型都有一串单词,研究人员测量了构成网络节点的活动。

然后者的然后,他们将这些模式与人类大脑中的活动进行了比较,并对执行三种语言任务的受试者进行了测量:听故事、一次读一个句子,以及每次读一个单词的句子。这些人体数据集包括功能性磁共振成像(fMRI, functional magnetic resonance imaging)数据和接受癫痫脑手术患者的颅内皮层脑电图测量。

结果表明,性能最好的单词预测模型的活动模式与人脑中的活动模式非常相似。这些相同模型中的活动与人类行为指标高度相关,例如,人们阅读文本的速度。

Schrimpf 说,“我们发现,能够很好地预测神经反应的模型也倾向于以阅读时间的形式最好地预测人类的行为反应。然后通过下一个单词预测的模型性能来解释这两个问题。这个三角形真的把一切联系在一起。”

改变游戏规则

预测模型(如 GPT-3)的关键计算特性之一,是一个称为正向单向预测 transformer 的元件。这种 transformer 能够根据之前的序列预测接下来会发生什么。它的显著特征在于,可以基于文本中篇幅较大的上下文(数百个单词)进行预测,而不仅仅是最后几个单词。

Tenenbaum 说,科学家还没有发现任何与这种处理方式相对应的大脑回路或学习机制。不过,新的发现与先前提出的假设保持着高度一致,即预测是语言处理的关键功能之一。

“语言处理的挑战之一是它的实时性,”他强调到。“语言输入进来后,你必须跟上它的节奏,并且能够实时理解它的含义。”

研究人员现在计划构建这些语言处理模型的变体,以了解其结构的微小变化是如何影响性能表现和适应人类神经数据的能力的。

“对我来说,这个结果改变了游戏规则,” Fedorenko 说道。“这完全改变了我的研究项目,因为我没有预料到,在我有生之年,会得到这些计算清晰的模型。这些模型能够捕捉到足够多的大脑信息,这样我们就可以真正利用它们来理解大脑的工作原理。”

研究人员还计划尝试将这些高性能语言模型与 Tenenbaum 实验室先前开发的一些计算机模型相结合,这些模型可以执行一些其他类型的任务,比如,构建物理世界的感知表征等。

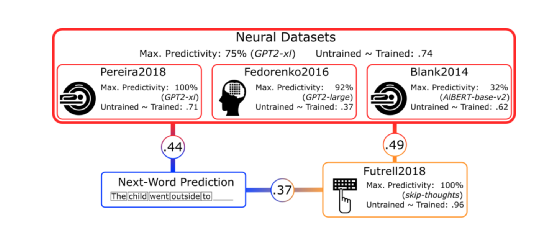

上图为该研究的主要结论,包括特定的 ANN 语言模型可以预测人类的神经对语言输入的高精度响应。

Tenenbaum 说,“如果我们能够理解这些语言模型的作用,以及它们如何与那些更像是做感知和思考的模型相联系,那么,我们很可能会得到更多关于大脑如何工作的综合性模型。这可能会让我们构建出更完善的、性能更佳的 AI 模型。当然,我们也可以更多地了解大脑究竟如何工作,以及通用智能是如何出现的,以丰富过去的知识盲区。”

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。